La tecnología sigue creciendo a pasos agigantados, apoyándose de varias áreas para explorar nuevas capacidades y funciones. Una de ellas es poder “reconstruir” la cara de una persona a través de un fragmento de voz.

El estudio Speech2Face presentado el 2019 en una conferencia de Visión y Patrones de reconocimiento mostró que una Inteligencia Artificial (AI) puede descifrar el aspecto de una persona a través de segmentos cortos de audio.

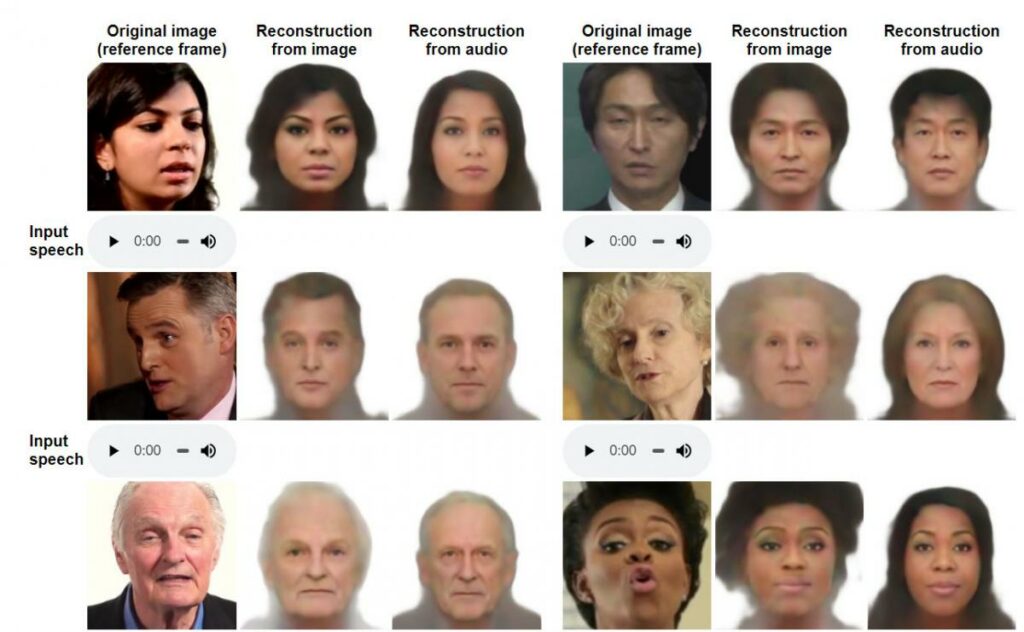

En el documento, se explica que la meta de los investigadores Tae-Hyun On, Tali Dekel, Changil Kim, Inbar Mosseri, William T. Freeman y Michael Rubinstein del Programa de Investigación y Ciencia del MIT, no es la de reconstruir de forma idéntica los rostros de las personas sino hacer una imagen con las características físicas que estén relacionadas con el audio analizado.

Para lograrlo usaron, diseñaron y entrenaron una red neuronal profunda que analizó millones de videos tomados de YouTube en donde hay personas hablando. Durante el entrenamiento el modelo aprendió a correlacionar las voces con los rostros, permitiéndole producir imágenes con atributos físicos similares a los hablantes, incluyendo la edad, género y etnicidad.

El entrenamiento fue realizado bajo supervisión y utilizando la concurrencia de las caras y voces de los videos de Internet, sin necesidad de modelar características físicas detalladas de la cara.

“Nuestras reconstrucciones, obtenidas directamente del audio, revelan las correlaciones entre rostros y voces. Evaluamos y cuantificamos numéricamente cómo, y de qué manera, nuestras reconstrucciones Speech2Face a partir de audio se asemejan a las imágenes reales de los rostros de los hablantes”.

Detallaron que debido a que este estudio podría tener aspectos sensibles por la etnicidad, así como por la privacidad, es que no se han añadido aspectos físicos específicos a la recreación de rostros y aseguran que al igual que cualquier otro sistema de machine learning, este va mejorando con el tiempo, ya que en cada uso aumenta su biblioteca de conocimientos.

Si bien sus pruebas mostradas dejan ver que Speech2Face tiene un alto número de coincidencias de los rostros con las voces, también tuvo algunas fallas, en donde no coincidió la etnicidad, la edad o el género con la muestra de voz utilizada.

El modelo está designado para presentar correlaciones estadísticas que existen entre las características faciales con la voz. Cabe recordar que la IA aprendió por videos de YouTube, los cuales no representan una muestra real de la población en el mundo, por ejemplo, en algunos idiomas muestra discrepancias con los datos de entrenamiento.

En ese sentido el propio estudio recomienda al final de sus resultados, que quienes decidan explorar y modernizar el sistema, tomen en consideración una muestra más amplia de personas y voces para que de ese modo el machine learning tenga un repertorio más amplio de emparejamiento y recreación de caras.

El programa también pudo hacer la recreación de la voz en caricaturas, las cuales también tienen un increíble parecido con las voces de los audios analizados.

Debido a que esta tecnología también podría ser usada para fines maliciosos, la recreación de la cara solo se mantiene lo más parecido a la persona y no da rostros completos, pues esto podría ser un problema para la privacidad de las personas. Aún así ha sorprendido lo que puede hacer la tecnología a partir de muestras de audio.